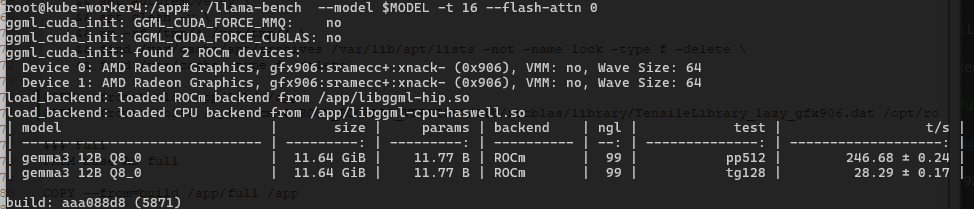

Локальные языковые модели (LLM): LLaMA, Gemma, DeepSeek и прочие №145 /llama/

Аноним

08/07/25 Втр 21:53:45

№

1